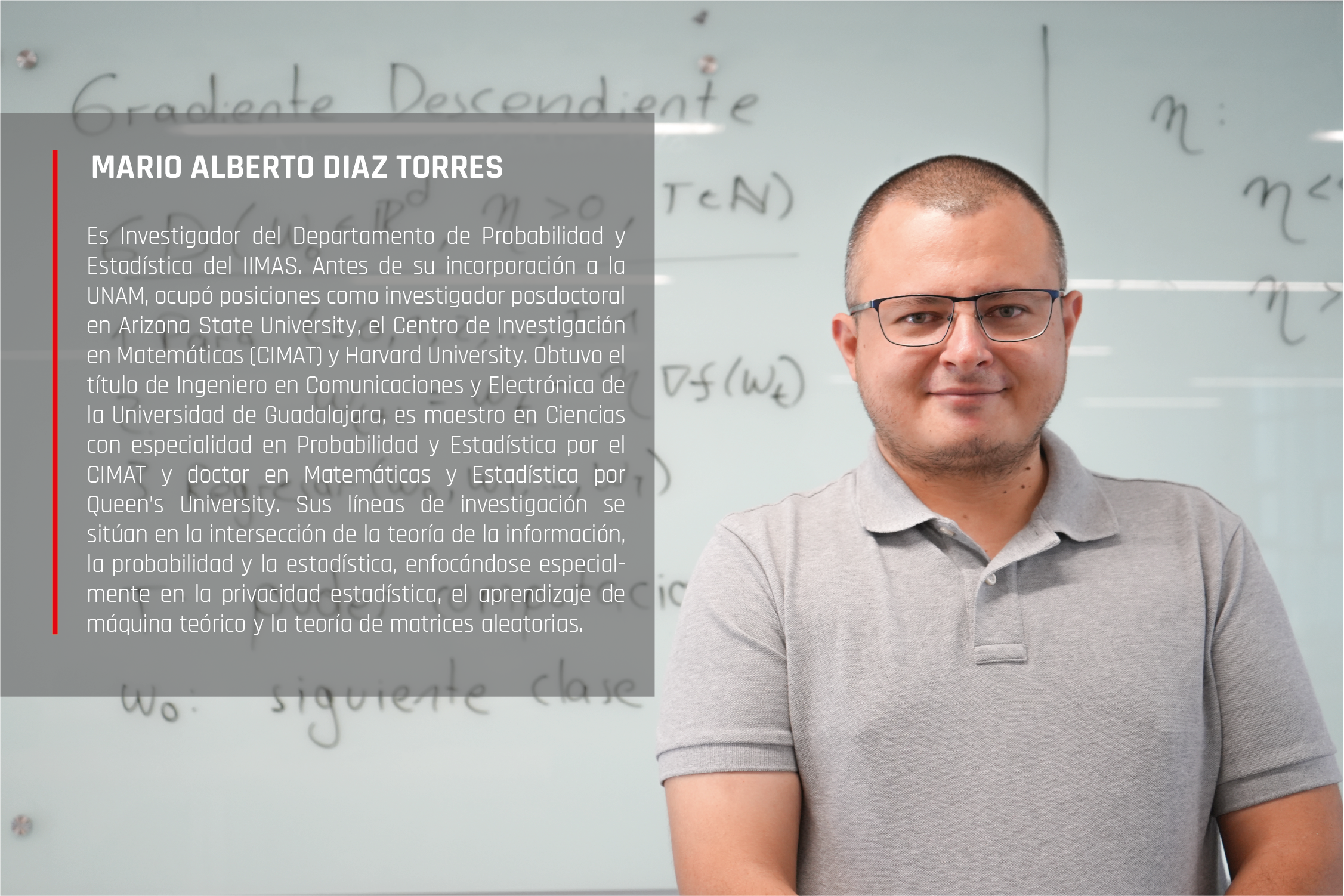

Al respecto el doctor Mario Diaz Torres, investigador del Departamento de Probabilidad y Estadística del Instituto de Investigaciones en Matemáticas Aplicadas y en Sistemas (IIMAS) estudia este tema, “básicamente queremos conocer qué tan privadas son las metodologías estadísticas y de machine learning. –una subdisciplina de la inteligencia artificial (IA) que se enfoca en el desarrollo de algoritmos y modelos que permiten a las computadoras aprender a partir de datos, de esta manera, en lugar de ser programadas para realizar una tarea, éstas aprenden patrones y reglas directamente de los datos, mejorando su desempeño con la experiencia–”. En el ámbito matemático, la privacidad abarca un rango que va desde enfoques muy prácticos hasta conceptos más teóricos. “En los proyectos en los que estoy trabajando, nos enfocamos en este último aspecto teórico. Nuestro objetivo es comprender los límites fundamentales de la privacidad, particularmente en una metodología llamada Differential Privacy Stochastic Gradient Descent (DP-SGD). Esta metodología se utiliza para entrenar modelos de machine learning y garantiza que los datos individuales permanezcan privados. Para lograr esto, incorpora mecanismos de Privacidad Diferencial”, explica.

Cómo las matemáticas aseguran la privacidad en el análisis de datos Cuando se aborda la privacidad desde un enfoque matemático, se estudia cómo dos conjuntos de datos (o distribuciones de probabilidad) se diferencian entre sí. Esta diferencia se mide utilizando una herramienta matemática conocida como divergencia hockey stick, que es una extensión del concepto de variación total. “La utilización de la divergencia hockey stick para medir la privacidad fue desarrollada principalmente por científicos de la computación. Actualmente, grandes empresas tecnológicas como Google, Facebook y Amazon emplean esta métrica para proteger la privacidad de los datos de sus usuarios. Esta herramienta les permite garantizar que los datos individuales no sean fácilmente identificables, asegurando su privacidad”, comenta.

El concepto central de la privacidad diferencial es que no debería ser posible determinar si una persona específica participó en un análisis estadístico o en el entrenamiento de un algoritmo de machine learning. Esto está diseñado para proteger contra lo que se conoce como “membership attacks” (ataques de membresía); sin embargo, para el doctor Diaz, la privacidad también debería implicar que no se pueda identificar información sensible de una persona, más allá de si participó o no.

Él señala que esta noción de privacidad es muy técnica y que, aunque la privacidad diferencial es la más utilizada hoy en día, especialmente porque es respaldada por grandes compañías, otras nociones de privacidad podrían surgir a medida que la comunidad estadística se involucre más en este tema. Comparar la privacidad con conceptos difíciles de definir como el amor, indica lo complejo que es capturar con precisión lo que significa “privado” en términos matemáticos.

De la teoría a la práctica: desafíos en la privacidad de los datos

A diferencia del machine learning clásico, donde se prueba un modelo y se ajusta según los resultados, en la privacidad, se necesitan garantías desde el inicio. Si al implementar un modelo se compromete la privacidad de alguien, no hay forma de revertir ese daño. Por eso, es crucial que las metodologías para garantizar la privacidad estén fundamentadas en sólidas bases teóricas. Una de las formas más sencillas de proteger la privacidad es mediante la adición de ruido a los datos. Al hacerlo, se dificulta la identificación de la participación de cualquier individuo en un conjunto de datos. Sin embargo, analizar y calcular la efectividad de este enfoque involucra conceptos teóricos avanzados, como las divergencias, que permiten evaluar cuánta privacidad se está ofreciendo realmente.

El doctor Mario Diaz Torres, junto con sus colegas, trabaja en mejorar estos mecanismos. Una de sus preguntas clave es: ¿cuál es la mejor manera de añadir ruido para maximizar la privacidad sin comprometer demasiado la precisión estadística? Este tipo de preguntas teóricas no sólo abordan la privacidad desde un enfoque práctico, sino que buscan determinar los límites de lo que es posible en términos de protección de datos.

En este contexto, la teoría de la información juega un papel fundamental, ya que esta disciplina permite explorar los límites entre lo que es posible y lo que no lo es. Mientras que en la práctica, demostrar que algo es posible puede ser relativamente sencillo, realizarlo para algo que es imposible requiere un profundo análisis matemático, lo que convierte a esta rama de la matemática en una especie de “magia” que define con precisión las fronteras del conocimiento y las capacidades tecnológicas.

Uso responsable del machine learning

Existe un parámetro clave que mide la privacidad en los modelos de machine learning: cuanto más pequeño es este valor, mejor es la privacidad; un valor de cero sería lo ideal, mientras que un valor infinito indica una total falta de privacidad. En teoría, “las empresas deberían establecer un nivel de privacidad específico, como un parámetro de ε= 5, y trabajar con él; sin embargo, de manera informal se sabe que en la práctica, muchas empresas ajustan este parámetro según la utilidad de los datos: si los datos con un valor de ε= 5 son útiles, lo dejan así; si no, aumentan el rango hasta obtener los resultados deseados”, menciona.

Un ejemplo notable es Apple, que en un momento llegó a utilizar un valor de epsilon igual a 16, lo cual es problemático, ya que la degradación de la privacidad no es lineal, sino exponencial. Pasar de un valor de 5 a 20 implica una pérdida de privacidad masiva, lo que básicamente anula cualquier protección. Este enfoque se debe en gran medida a motivos económicos, ya que las empresas suelen priorizar la utilidad de los datos sobre la privacidad para evitar perder rendimiento. A veces, simplemente ajustan estos valores para poder afirmar que sus productos son “privados”, con el objetivo de vender más, aunque en realidad no estén garantizando una privacidad robusta.

Este problema pone de manifiesto la necesidad de legislaciones adecuadas que regulen cómo se manejan estos parámetros de privacidad, aunque, la creación y aplicación de estas leyes presenta múltiples desafíos: desde cómo formularlas correctamente hasta cómo asegurarse de que sean comprensibles y aplicables por los legisladores. A pesar de estos retos, las iniciativas actuales, muchas impulsadas por la presión de los consumidores sobre las empresas, son un paso en la dirección correcta. La lucha por equilibrar la privacidad con la utilidad de los datos es constante, y todavía hay más preguntas que respuestas en este campo.

A su vez, el doctor Mario Diaz Torres también ha estado trabajando para involucrar a estudiantes en temas de privacidad, particularmente en la creación de material educativo a nivel licenciatura. Actualmente, coordina un programa de servicio social enfocado en desarrollar recursos que expliquen los fundamentos del machine learning y del machine learning privado. Señala que, aunque existen artículos de divulgación muy básicos y numerosos trabajos de investigación avanzada, hay una falta de material intermedio accesible para estudiantes universitarios. Este vacío se debe, en parte, a la complejidad técnica de conceptos como la privacidad y la dificultad de caracterizarlos matemáticamente.

Finalmente, destaca la importancia de crear una cultura y una comunidad de privacidad, pero también subraya que su objetivo a largo plazo es promover el uso responsable del machine learning. Esto no sólo incluye la privacidad, sino también otros temas como la equidad, aunque éstos pueden estar fuera de su zona de confort en términos de investigación, considera que es esencial expandir sus proyectos, involucrando a estudiantes y aplicaciones prácticas, porque cree firmemente en el valor que esto puede aportar a la sociedad.